Este post no surge de la nada. Para escribir con total sinceridad, este post surge por inspiración de una publicación de Linkedin de Iván Leal. Aquí está

Porque en el club digital creemos que debemos inspirarnos en otros/as pero siempre con respecto y haciendo alusión a la fuente original. Gracias Iván Leal Durán por mostrarnos esta teoría de la «habitación china» que nos ha “picado el gusanillo” tanto como para querer investigar más sobre ella y reflexionar en nuestro club digital.

La teoría de la habitación china

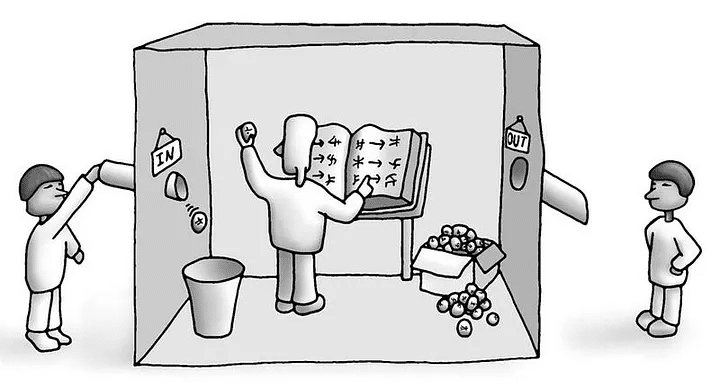

Imagina una habitación cerrada. Dentro hay una persona que no sabe nada de chino. No comprende sus caracteres, no conoce su gramática ni su cultura. Pero dispone de un manual con reglas muy precisas que le dicen qué hacer con cada símbolo que entra por una ranura y qué respuesta debe devolver. Desde fuera, alguien le envía preguntas en chino y recibe respuestas perfectamente coherentes, incluso ingeniosas. Cualquiera pensaría que dentro hay una persona que entiende el idioma. Pero no es así. Solo hay alguien siguiendo instrucciones.

Esta es la famosa “Habitación China”, el experimento mental que el filósofo John Searle propuso en 1980 para cuestionar una idea que en aquel momento (y todavía hoy) divide a la comunidad científica ¿Puede una máquina realmente entender lo que hace, o simplemente procesa símbolos sin comprenderlos?

Searle imaginó este escenario para criticar lo que él llamó la Inteligencia Artificial Fuerte, la idea de que un ordenador, con el programa adecuado, no solo podría simular el pensamiento humano, sino tener una mente genuina, con comprensión y conciencia. Según su razonamiento, la persona dentro de la habitación representa lo que hace un ordenador: manipula información de forma sintáctica, siguiendo reglas, pero sin acceso al significado, sin semántica. Puede dar la impresión de entender, pero no entiende nada.

Entre la sintaxis y la semántica

La Habitación China nos obliga a diferenciar entre hacer y entender lo que se hace. Entre simular la inteligencia y poseer inteligencia.

Un modelo de lenguaje como los que usamos hoy, capaz de mantener una conversación, redactar un texto o responder preguntas complejas, parece demostrar una forma de comprensión. Pero ¿lo hace realmente? ¿O simplemente asocia patrones de palabras según reglas estadísticas?

Searle sostenía que no importa cuán sofisticado sea el sistema: si lo único que hace es manipular símbolos según un conjunto de reglas, no hay entendimiento real. Es como si alguien pronunciara una poesía en un idioma que desconoce: reproduce los sonidos, pero no vive su significado.

Este matiz, la diferencia entre sintaxis y semántica, es el corazón del debate actual sobre la inteligencia artificial. Y no es solo un dilema filosófico: tiene implicaciones directas en cómo entendemos la relación entre humanos y máquinas, cómo diseñamos sistemas éticos y cómo valoramos el papel de la conciencia y la empatía en la tecnología.

Críticas y nuevas miradas

Desde su publicación, el experimento de Searle ha generado tanto adhesiones como críticas.

Algunos filósofos y científicos sostienen que Searle se equivoca al centrarse en la persona dentro de la habitación. Para ellos, el sistema completo (la persona, el manual y la habitación) sí podría considerarse un ente que “entiende”, aunque sus componentes por separado no lo hagan. Es el llamado argumento del sistema.

Otros apuntan que la analogía es limitada, porque los humanos no procesamos información de manera puramente simbólica. Nuestro pensamiento está anclado en la experiencia corporal, sensorial y emocional. En esa línea, algunas teorías más recientes, como la cognición encarnada, defienden que una máquina podría aproximarse al entendimiento real si tuviera cuerpo, contexto y capacidad de interactuar con el mundo físico, no solo con datos abstractos.

Y sin embargo, incluso con esas matizaciones, la intuición que plantea Searle sigue viva, algo esencial parece faltar en la comprensión artificial. Algo que tiene que ver con la conciencia subjetiva, con el “saber que se sabe”.

Una conversación más vigente que nunca

Cuarenta años después, la Habitación China sigue siendo una metáfora poderosa para pensar la tecnología contemporánea. En tiempos de modelos de lenguaje generativo, asistentes virtuales y chatbots que escriben, debaten y hasta bromean, la pregunta de Searle vuelve con fuerza ¿están entendiendo o simplemente calculando?

Quizás la cuestión no sea solo si las máquinas pueden pensar como nosotros/as, sino si nosotros/as entendemos bien qué significa pensar. Tal vez, como sugería el propio Searle, la inteligencia humana no sea reducible a algoritmos, porque implica una dimensión experiencial, una vivencia interior que ningún código puede replicar.

O tal vez, al contrario, lo que llamamos “comprensión” sea solo un patrón complejo de procesamiento que también podría emerger, algún día, de un sistema suficientemente avanzado.

Una invitación a mirar con cuidado

Más allá del debate filosófico, la Habitación China nos recuerda algo importante para el mundo de la tecnología social, no basta con crear herramientas que respondan correctamente. Necesitamos que esas herramientas se desarrollen con conciencia ética, con sensibilidad humana, con propósito.

Porque si las máquinas no entienden, somos las personas quienes debemos entender por ellas. Entender sus límites, sus sesgos, sus impactos y su papel en la sociedad.

El futuro de la inteligencia artificial no se juega solo en los laboratorios, sino también en nuestra capacidad colectiva para reflexionar, regular y acompañar su desarrollo.

Y en ese sentido, tal vez el experimento de Searle siga siendo, más que una paradoja, una brújula.

Fuentes:

https://medium.com/%40transphilosophr/searles-chinese-room-thought-experiment-a-twist-c7eb28f65e6c

https://es.wikipedia.org/wiki/Habitaci%C3%B3n_china

Imágenes: Freepik & wikicommons

Si te interesa la Tecnología Social, este es tu sitio. 🙂

Apúntate a nuestra newsletter

Te acercamos a la Tecnología Social desde todas sus perspectivas

Síguenos

En nuestras redes podrás tener información fresquita sobre La Rueca Asociación